Caractéristiques des distributions de probabilités discrètes, exercices

le distributions de probabilité discrètes il s'agit d'une fonction qui attribue à chaque élément de X (S) = x1, x2,…, xi,…, où X est une variable aléatoire discrète donnée et S est son espace d'échantillonnage, la probabilité que ledit événement se produise. Cette fonction f de X (S) définie comme f (xi) = P (X = xi) est parfois appelée fonction de masse de probabilité.

Cette masse de probabilités est généralement représentée sous forme de tableau. Puisque X est une variable aléatoire discrète, X (S) a un nombre fini d'événements ou une infinité dénombrable. Parmi les distributions de probabilités discrètes les plus courantes, nous avons la distribution uniforme, la distribution binomiale et la distribution de Poisson.

Index des articles

- 1 Fonctionnalités

- 2 types

- 2.1 Distribution uniforme sur n points

- 2.2 Distribution binomiale

- 2.3 Distribution de Poisson

- 2.4 Distribution hypergéométrique

- 3 exercices résolus

- 3.1 Premier exercice

- 3.2 Deuxième exercice

- 3.3 Troisième exercice

- 3.4 Troisième exercice

- 4 Références

Caractéristiques

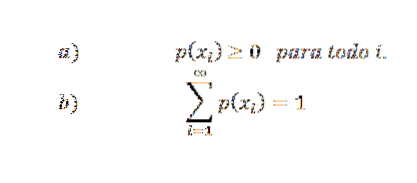

La fonction de distribution de probabilité doit répondre aux conditions suivantes:

De plus, si X ne prend qu'un nombre fini de valeurs (par exemple x1, x2,…, xn), alors p (xi) = 0 si i> ny, donc, la série infinie de la condition b devient une série finie.

Cette fonction remplit également les propriétés suivantes:

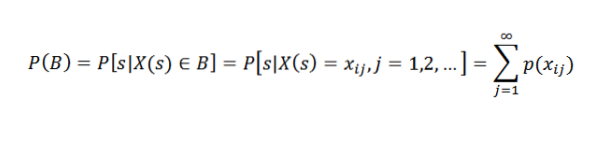

Soit B un événement associé à la variable aléatoire X. Cela signifie que B est contenu dans X (S). Plus précisément, supposons que B = xi1, xi2,…. Donc:

En d'autres termes: la probabilité d'un événement B est égale à la somme des probabilités des résultats individuels associés à B.

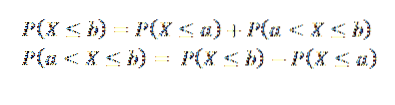

De cela, nous pouvons conclure que si un < b, los sucesos (X ≤ a) y (a < X ≤ b) son mutuamente excluyentes y, además, su unión es el suceso (X ≤ b), por lo que tenemos:

Les types

Distribution uniforme sur n points

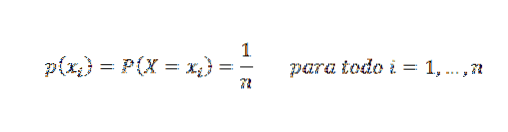

On dit qu'une variable aléatoire X suit une distribution caractérisée par son uniformité en n points si chaque valeur se voit attribuer la même probabilité. Sa fonction de masse de probabilité est:

Supposons que nous ayons une expérience qui a deux résultats possibles, cela peut être le tirage au sort d'une pièce dont les résultats possibles sont face ou face, ou le choix d'un entier dont le résultat peut être un nombre pair ou impair; ce type d'expérience est connu sous le nom de tests de Bernoulli.

En général, les deux résultats possibles sont appelés succès et échec, où p est la probabilité de succès et 1-p est la probabilité d'échec. Nous pouvons déterminer la probabilité de x succès dans n tests de Bernoulli indépendants les uns des autres avec la distribution suivante.

Distribution binomiale

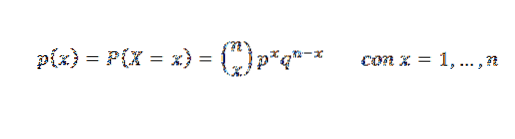

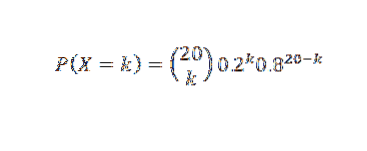

C'est la fonction qui représente la probabilité d'obtenir x succès dans n tests de Bernoulli indépendants, dont la probabilité de succès est p. Sa fonction de masse de probabilité est:

Le graphique suivant représente la fonction de masse de probabilité pour différentes valeurs des paramètres de la distribution binomiale.

La distribution suivante doit son nom au mathématicien français Siméon Poisson (1781-1840), qui l'a obtenue comme limite de la distribution binomiale.

Distribution de Poisson

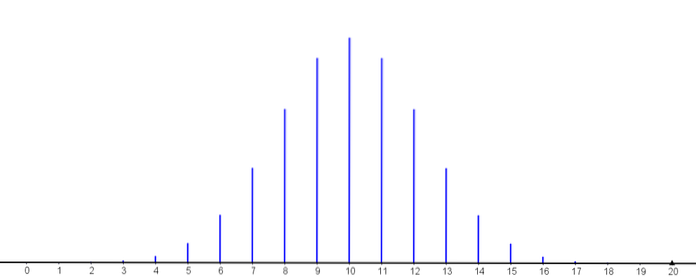

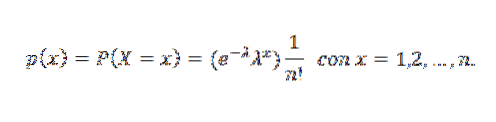

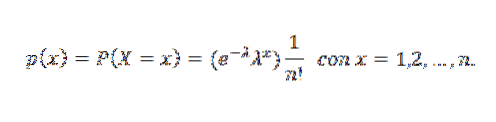

Une variable aléatoire X est dite avoir une distribution de Poisson de paramètre λ lorsqu'elle peut prendre les valeurs entières positives 0,1,2,3, ... avec la probabilité suivante:

Dans cette expression, λ est le nombre moyen correspondant aux occurrences de l'événement pour chaque unité de temps, et x est le nombre de fois où l'événement se produit.

Sa fonction de masse de probabilité est:

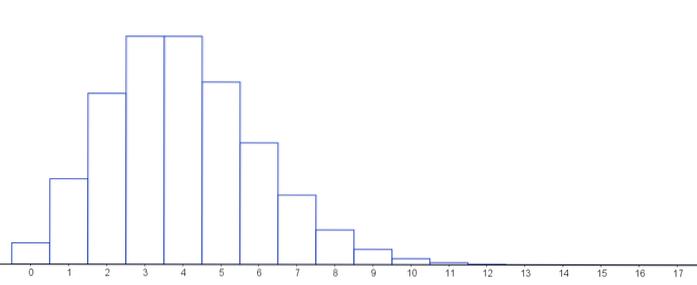

Ensuite, un graphique qui représente la fonction de masse de probabilité pour différentes valeurs des paramètres de la distribution de Poisson.

Notez que tant que le nombre de succès est faible et que le nombre de tests effectués sur une distribution binomiale est élevé, on peut toujours approcher ces distributions, car la distribution de Poisson est la limite de la distribution binomiale.

La principale différence entre ces deux distributions est que, alors que le binôme dépend de deux paramètres - à savoir, n et p-, le Poisson ne dépend que de λ, qui est parfois appelé l'intensité de la distribution..

Jusqu'à présent, nous n'avons parlé des distributions de probabilité que pour les cas où les différentes expériences sont indépendantes les unes des autres; c'est-à-dire, lorsque le résultat de l'un n'est pas affecté par un autre résultat.

Lorsque le cas d'expériences non indépendantes se produit, la distribution hypergéométrique est très utile.

Distribution hypergéométrique

Soit N le nombre total d'objets d'un ensemble fini, dont nous pouvons identifier k de ceux-ci d'une certaine manière, formant ainsi un sous-ensemble K, dont le complément est formé par les N-k éléments restants.

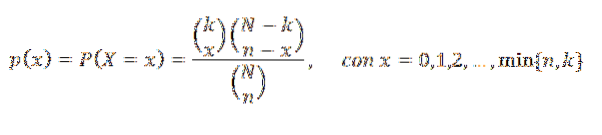

Si l'on choisit aléatoirement n objets, la variable aléatoire X qui représente le nombre d'objets appartenant à K dans ledit choix a une distribution hypergéométrique des paramètres N, n et k. Sa fonction de masse de probabilité est:

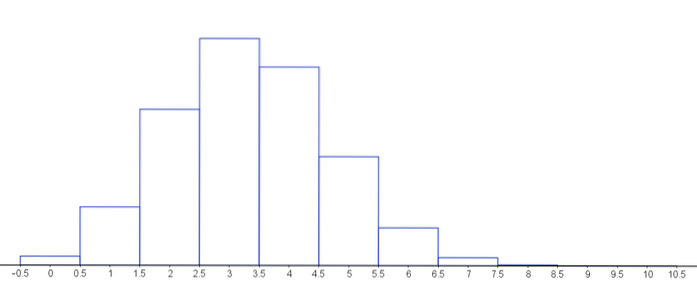

Le graphique suivant représente la fonction de masse de probabilité pour différentes valeurs des paramètres de la distribution hypergéométrique.

Exercices résolus

Premier exercice

Supposons que la probabilité qu'un tube radio (placé dans un certain type d'équipement) fonctionne pendant plus de 500 heures est de 0,2. Si 20 tubes sont testés, quelle est la probabilité qu'exactement k d'entre eux fonctionnent pendant plus de 500 heures, k = 0, 1,2,…, 20?

Solution

Si X est le nombre de tubes qui fonctionnent plus de 500 heures, nous supposerons que X a une distribution binomiale. Ensuite

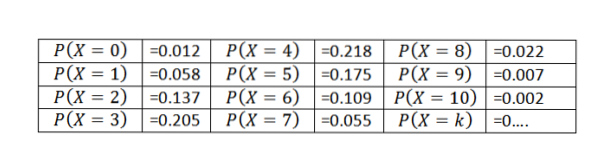

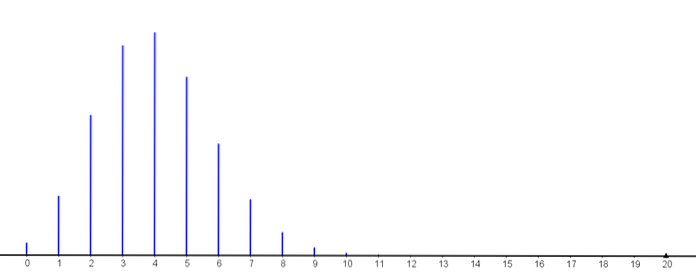

Et donc:

Pour k ≥ 11, les probabilités sont inférieures à 0,001

Ainsi, nous pouvons observer comment la probabilité que k de ceux-ci travaillent pendant plus de 500 heures augmente, jusqu'à atteindre sa valeur maximale (avec k = 4) puis commence à diminuer..

Deuxième exercice

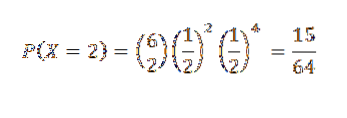

Une pièce est lancée 6 fois. Quand le résultat est cher, on dira que c'est une réussite. Quelle est la probabilité que deux têtes apparaissent exactement?

Solution

Pour ce cas, nous avons n = 6 et les probabilités de succès et d'échec sont p = q = 1/2

Par conséquent, la probabilité que deux têtes soient données (c'est-à-dire k = 2) est

Troisième exercice

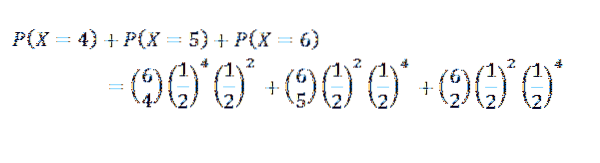

Quelle est la probabilité de trouver au moins quatre têtes?

Solution

Pour ce cas, nous avons que k = 4, 5 ou 6

Troisième exercice

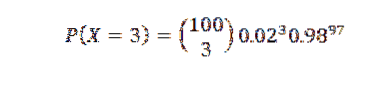

Supposons que 2% des articles produits dans une usine sont défectueux. Trouvez la probabilité P qu'il y ait trois articles défectueux dans un échantillon de 100 articles.

Solution

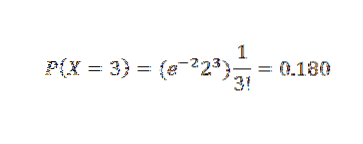

Pour ce cas, nous pourrions appliquer la distribution binomiale pour n = 100 et p = 0,02 en obtenant comme résultat:

Cependant, puisque p est petit, nous utilisons l'approximation de Poisson avec λ = np = 2. A) Oui,

Les références

- Kai Lai Chung. Théorie élémentaire de la rentabilité avec des processus stochastiques. Springer-Verlag New York Inc

- Kenneth.H. Rosen: Mathématiques discrètes et ses applications. S.A. MCGRAW-HILL / INTERAMERICANA DE ESPAÑA.

- Paul L. Meyer. Probabilité et applications statistiques. S.A. ALHAMBRA MEXICAIN.

- Seymour Lipschutz Ph.D. 2000 Problèmes résolus de mathématiques discrètes. McGRAW-HILL.

- Seymour Lipschutz Ph.D. Problèmes de théorie et de probabilité. McGRAW-HILL.

Personne n'a encore commenté ce post.