Concept de probabilité de fréquence, comment il est calculé et exemples

La la probabilité de fréquence est une sous-définition dans l'étude de la probabilité et de ses phénomènes. Sa méthode d'étude des événements et des attributs est basée sur de grandes quantités d'itérations, observant ainsi l'évolution de chacun sur le long terme voire à des répétitions infinies..

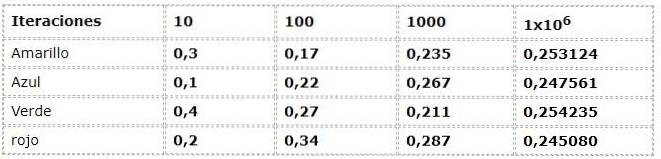

Par exemple, une enveloppe de bonbons contient 5 gommes de chaque couleur: bleu, rouge, vert et jaune. Nous voulons déterminer la probabilité que chaque couleur doit sortir après une sélection aléatoire.

Il est fastidieux d'imaginer sortir un caoutchouc, l'enregistrer, le renvoyer, sortir un caoutchouc et répéter la même chose plusieurs centaines ou plusieurs milliers de fois. Vous voudrez peut-être même observer le comportement après plusieurs millions d'itérations.

Mais au contraire, il est intéressant de découvrir qu'après quelques répétitions, la probabilité attendue de 25% n'est pas pleinement atteinte, du moins pas pour toutes les couleurs après 100 itérations..

Sous l'approche de la probabilité de fréquence, l'attribution des valeurs se fera uniquement par l'étude de nombreuses itérations. De cette manière, le processus doit être effectué et enregistré de préférence de manière informatisée ou émulée.

Les courants multiples rejettent la probabilité de fréquence, arguant du manque d'empirisme et de fiabilité des critères d'aléa.

Index des articles

- 1 Comment la probabilité de fréquence est-elle calculée?

- 1.1 Loi des grands nombres

- 2 Autres approches de la probabilité

- 2.1 Théorie logique

- 2.2 Théorie subjective

- 3 Histoire

- 3.1 Phénomènes de masse et événements répétitifs

- 3.2 Attributs

- 4 Exemple

- 4.1 Références

Comment la probabilité de fréquence est-elle calculée?

En programmant l'expérience dans n'importe quelle interface capable d'offrir une itération purement aléatoire, on peut commencer à étudier la probabilité fréquentielle du phénomène à l'aide d'un tableau de valeurs.

L'exemple précédent peut être vu à partir de l'approche fréquentielle:

Les données numériques correspondent à l'expression:

N (a) = Nombre d'occurrences / Nombre d'itérations

Où N (a) représente la fréquence relative de l'événement "a"

"A" appartient à l'ensemble des résultats possibles ou à l'espace d'échantillonnage Ω

Ω: rouge, vert, bleu, jaune

Une dispersion considérable est appréciée dans les premières itérations, lors de l'observation de fréquences avec jusqu'à 30% de différences entre elles, ce qui est une donnée très élevée pour une expérience qui a théoriquement des événements avec la même possibilité (équiprobable).

Mais au fur et à mesure que les itérations grandissent, les valeurs semblent s'ajuster de plus en plus à celles présentées par le courant théorique et logique.

Loi des grands nombres

Comme un accord inattendu entre les approches théorique et fréquentielle apparaît la loi des grands nombres. Où il est établi qu'après un nombre considérable d'itérations, les valeurs de l'expérience fréquentielle se rapprochent des valeurs théoriques.

Dans l'exemple, vous pouvez voir comment les valeurs approchent de 0,250 à mesure que les itérations se développent. Ce phénomène est élémentaire dans les conclusions de nombreux travaux probabilistes.

Autres approches de la probabilité

Il existe 2 autres théories ou approches de la notion de probabilité en plus de la probabilité de fréquence.

Théorie logique

Son approche est orientée vers la logique déductive des phénomènes. Dans l'exemple précédent, la probabilité d'obtenir chaque couleur est de 25% de manière fermée. Autrement dit, leurs définitions et axiomes ne prennent pas en compte les décalages en dehors de leur gamme de données probabilistes..

Théorie subjective

Il est basé sur les connaissances et les croyances antérieures que chaque individu a sur les phénomènes et les attributs. Des déclarations telles que "Il pleut toujours à Pâques " Ils sont dus à un modèle d'événements similaires qui se sont produits précédemment.

Histoire

Les débuts de sa mise en œuvre remontent au 19e siècle, lorsque Venn l'a cité dans plusieurs de ses œuvres à Cambridge en Angleterre. Mais ce n'est que bien dans le XXe siècle que 2 mathématiciens statistiques ont développé et façonné le probabilité de fréquence.

L'un d'eux était Hans Reichenbach, qui développe son travail dans des publications telles que "The Theory of Probability" publié en 1949.

L'autre était Richard Von Mises, qui a développé son travail à travers de multiples publications et a proposé de considérer la probabilité comme une science mathématique. Ce concept était nouveau en mathématiques et inaugurerait une ère de croissance dans l'étude des mathématiques. probabilité de fréquence.

En fait, cet événement marque la seule différence avec les contributions des générations Venn, Cournot et Helm. Où la probabilité devient homologue à des sciences telles que la géométrie et la mécanique.

< La teoría de las probabilidades trata con phénomènes massifs et événements répétitifs. Problèmes dans lesquels soit le même événement se répète encore et encore, soit un grand nombre d'éléments uniformes sont impliqués en même temps> Richard Von Mises

Phénomènes massifs et événements répétitifs

Trois types peuvent être classés:

- Physique: ils obéissent aux modèles de la nature au-delà d'une condition d'aléatoire. Par exemple le comportement des molécules d'un élément dans un échantillon.

- Chance - Votre principale considération est le caractère aléatoire, comme lancer un dé à plusieurs reprises.

- Statistiques biologiques: sélections des sujets de test en fonction de leurs caractéristiques et attributs.

En théorie, l'individu qui mesure joue un rôle dans les données probabilistes, car ce sont ses connaissances et ses expériences qui articulent cette valeur ou cette prédiction..

Dans la probabilité de fréquence les événements seront considérés comme des collections à traiter, où l'individu ne joue aucun rôle dans l'estimation.

Les attributs

Un attribut apparaît dans chaque élément, qui sera variable selon sa nature. Par exemple, dans le type de phénomène physique, les molécules d'eau auront des vitesses différentes..

Au lancer des dés, nous connaissons l'espace échantillon Ω qui représente les attributs de l'expérience.

Ω: 1, 2, 3, 4, 5, 6

Il y a d'autres attributs comme être pair ΩP ou être impair Ωje

Ωp : 2, 4, 6

Ωje : 1, 3, 5

Qui peuvent être définis comme des attributs non élémentaires.

Exemple

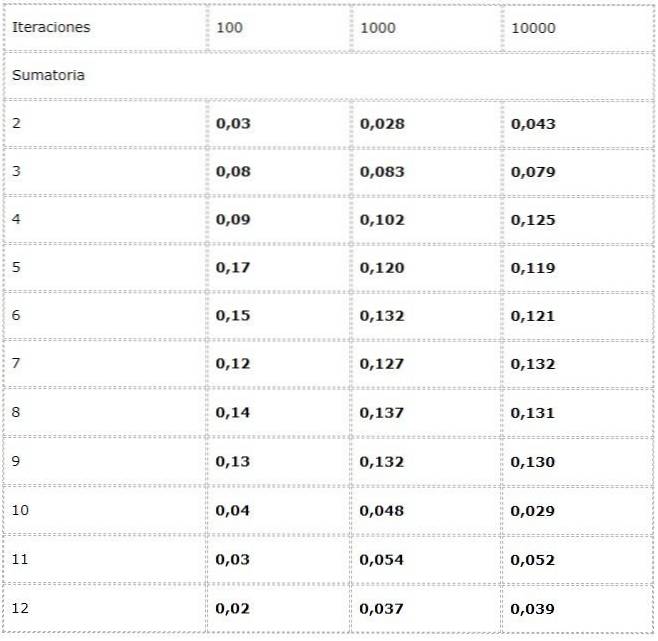

- On veut calculer la fréquence de chaque sommation possible au lancer de deux dés.

Pour cela, une expérience est programmée où deux sources de valeurs aléatoires entre [1, 6] sont ajoutées à chaque itération.

Les données sont enregistrées dans un tableau et les tendances en grand nombre sont étudiées.

On observe que les résultats peuvent varier considérablement entre les itérations. Cependant, la loi des grands nombres se retrouve dans l'apparente convergence présentée dans les deux dernières colonnes.

Les références

- Statistiques et évaluation des preuves pour les scientifiques légistes. Deuxième édition. Colin G.G. Aitken. École de mathématiques. L'Université d'Édimbourg, Royaume-Uni

- Mathématiques pour l'informatique. Eric Lehman. Google Inc.

F Thomson Leighton Département de mathématiques et Laboratoire d'informatique et d'IA, Massachusetts Institute of Technology; Technologies Akamai - The Arithmetic Teacher, Volume 29. National Council of Teachers of Mathematics, 1981. Université du Michigan.

- Apprentissage et enseignement de la théorie des nombres: recherche en cognition et instruction / édité par Stephen R. Campbell et Rina Zazkis. Publication Ablex 88 Post Road West, Westport CT 06881

- Bernoulli, J. (1987). Ars Conjectandi- 4ème partie. Rouen: IREM.

Personne n'a encore commenté ce post.